MiMo-7B: Xiaomis KI-Revolution – Klein, aber Oho!

MiMo-7B: Xiaomis KI-Revolution – Klein, aber Oho!

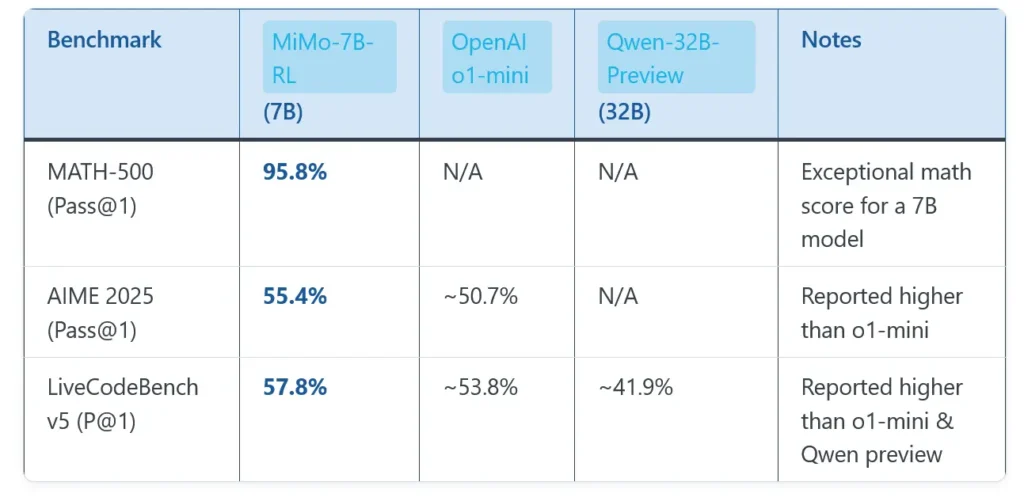

Xiaomi hat im April 2025 die KI-Welt ordentlich aufgeschüttelt! Mit MiMo-7B, ihrem ersten Open-Source-Sprachmodell, präsentiert der chinesische Tech-Gigant einen echten Überraschungscoup. Dieses kompakte Modell mit nur 7 Milliarden Parametern schlägt in wichtigen Benchmarks sogar deutlich größere Konkurrenten wie OpenAIs o1-mini oder Alibabas Qwen-32B. In diesem Artikel tauchen wir tief in die Welt von MiMo-7B ein und zeigen, warum dieses kleine Sprachmodell eine große Sache ist.

Was ist MiMo-7B eigentlich?

MiMo-7B ist keine einzelne KI, sondern eine ganze Familie von Sprachmodellen, entwickelt vom Xiaomi Big Model Core Team – einem Spezialisten-Team, das Xiaomis KI-Forschung vorantreibt. Anders als viele andere Modelle, die sich vor allem auf allgemeine Konversationen konzentrieren, ist MiMo-7B auf komplexes logisches Denken, Mathematik und Programmierung spezialisiert. Stellt euch vor: Mathe-Aufgaben auf Universitätsniveau lösen, Code schreiben und Fehler finden – das alles soll MiMo-7B packen können!

Das Besondere: Mit seinen nur 7 Milliarden Parametern erreicht es eine Leistung, die mit deutlich größeren Modellen (manche haben 32 Milliarden Parameter!) vergleichbar ist. Das Geheimnis? Intelligentes Training und clevere Optimierungsmethoden. Xiaomi bietet gleich vier Versionen unter der Open-Source-Lizenz Apache 2.0 an, verfügbar auf Hugging Face und GitHub:

- MiMo-7B-Base: Das Basismodell, trainiert auf logische Muster.

- MiMo-7B-SFT: Durch Supervised Fine-Tuning (überwachtes Feintuning) für höhere Genauigkeit optimiert.

- MiMo-7B-RL-Zero: Mit Reinforcement Learning (verstärkendes Lernen) aus dem Basismodell trainiert.

- MiMo-7B-RL: Die aktuell beste Version, mit RL aus dem SFT-Modell trainiert – der Spitzenreiter in Mathematik und Code.

Die Innovationen hinter MiMo-7B: Mehr als nur Größe zählt!

Der Erfolg von MiMo-7B beruht auf einem ganzheitlichen Ansatz, der sowohl das Vortraining als auch das Feintuning optimiert. Xiaomi hat dabei einige wirklich spannende Dinge umgesetzt.

Vortraining: Logisches Denken im Fokus

Xiaomi hat MiMo-7B von Grund auf mit Fokus auf „Dichte von logischen Mustern“ trainiert. Keine allgemeine Datenflut, sondern eine gezielte Auswahl:

- Hochwertige Daten: MiMo-7B-Base wurde mit 25 Billionen Tokens trainiert, davon 200 Milliarden speziell für das logische Denken. In einem dreistufigen Prozess wurde der Anteil an mathematischen und programmiertechnischen Inhalten schrittweise auf 70% erhöht, ergänzt durch 10% synthetische Daten.

- Multi-Token-Vorhersage (MTP): Anstatt nur das nächste Wort vorherzusagen, lernt MiMo-7B mehrere Tokens gleichzeitig – das verbessert das Kontextverständnis und beschleunigt die Verarbeitung.

- Mehrdimensionales Filtern: Xiaomi hat die Textextraktion verbessert und Filter eingesetzt, um Beispiele mit komplexen logischen Strukturen zu priorisieren.

Feintuning: Reinforcement Learning mit cleveren Tricks

Reinforcement Learning ist der Schlüssel zum herausragenden Ergebnis von MiMo-7B-RL. Xiaomi hat hier weitere innovative Methoden eingesetzt:

- Kuratierte Datensätze: 130.000 Mathematik- und Programmieraufgaben, verifiziert durch regelbasierte Systeme. Jede Aufgabe wurde nach Schwierigkeit klassifiziert.

- Schwierigkeitsbasierte Belohnungen: Um das Problem „spärlicher Belohnungen“ bei komplexen Aufgaben zu lösen, gibt es ein System, das nach Schwierigkeit gewichtete Punkte vergibt. Partiallösungen werden belohnt.

- Daten-Resampling: Um das Training zu stabilisieren, werden einfachere Aufgaben neu eingefügt, um die Effizienz zu steigern.

- Seamless Rollout Engine: Ein eigens entwickelter Engine, der das Training um 2,29x und die Validierung um 1,96x beschleunigt.

MiMo-VL-7B: Bilder verstehen, logisch denken

Xiaomi hat zusätzlich MiMo-VL-7B veröffentlicht, ein multimodaler Vision-Language-Model (VLM), welches visuelle Informationen und Textverarbeitung kombiniert. Dieses Modell glänzt durch:

- Einen hochauflösenden ViT-Encoder für detaillierte Bildanalyse.

- Einen MLP-Projektor für effizientes Zusammenführen von Bild- und Textdaten.

- Vierstufiges Training mit verstärktem Lernen.

- Die Erzielung der höchsten Elo-Bewertung unter Open-Source-VLM Modellen.

MiMo-7B im Test: Die Benchmarks sprechen für sich

MiMo-7B-RL erzielt in Standardtests herausragende Ergebnisse, oft besser als größere Modelle:

- Mathematik:

- MATH-500: 95.8% Genauigkeit (Pass@1)

- AIME 2024: 68.2% Pass@1

- AIME 2025: 55.4% Pass@1 (übertrifft DeepSeek R1 nach Datensatz-Skalierung)

- Programmierung:

- LiveCodeBench v5: 57.8% Pass@1

- LiveCodeBench v6: 49.3% Pass@1

- Allgemeines logisches Denken:

- GPQA Diamond: 54.4% Pass@1

- IF-Eval (Prompt Strict): 61.0% Pass@1

Wo wird MiMo-7B eingesetzt? Die Anwendungsgebiete

Die Kompaktheit und Effizienz von MiMo-7B machen es für viele Anwendungen ideal, besonders auf Geräten mit begrenzten Ressourcen:

- Bildung: Schritt-für-Schritt-Lösungsansätze für Matheaufgaben und Programmier-Tutorials.

- Softwareentwicklung: Automatisierung von Code-Debugging, Algorithmusoptimierung und Erstellung von Unit-Tests.

- Forschung: Unterstützung bei automatisierten Theorembeweisen und Datenanalysen.

- Edge Computing: Logisches Denken auf IoT-Geräten, Smartphones und anderen Systemen.

- Unternehmen: Anwendungen im Finanzwesen, Gesundheitswesen und der Logistik.

Xiaomi plant die Integration in das eigene Ökosystem (HyperOS, Xiao AI), was Smartphones, Smart Homes und E-Autos (z.B. Xiaomi SU7) intelligenter machen soll.

Open Source: Gemeinsam stärker!

Xiaomi hat MiMo-7B unter der Apache 2.0 Lizenz veröffentlicht – kostenlose Nutzung, Modifikation und kommerzielle Anwendung sind erlaubt! Modelle und Dokumentation findet man auf:

- Hugging Face: z.B. XiaomiMiMo/MiMo-7B-RL und MiMo-VL-7B-RL

- GitHub: Checkpoints für alle Versionen (Base, SFT, RL-Zero, RL)

Das fördert die Zusammenarbeit und positioniert Xiaomi als wichtigen Akteur bei der Demokratisierung der KI.

MiMo-7B im Vergleich: Die wichtigsten Unterschiede

| Merkmal | MiMo-7B-RL | OpenAI o1-mini | Alibaba Qwen-32B |

|---|---|---|---|

| Parameter | 7 Milliarden | Nicht spezifiziert (geschätzt >20B) | 32 Milliarden |

| Mathematik | 95.8% (MATH-500), 68.2% (AIME 2024) | Vergleichbar in AIME 2024 | Schlechter in AIME 2024 |

| Code-Generierung | 57.8% (LiveCodeBench v5) | Vergleichbar in LiveCodeBench | Schlechter in LiveCodeBench |

| Modellgröße | Kompakt, für Edge Computing geeignet | Größer, benötigt mehr Ressourcen | Größer, benötigt mehr Ressourcen |

| Lizenz | Apache 2.0 (Open Source) | Proprietär | Proprietär |

| Training | 25 Billionen Tokens, optimiertes RL | Nicht veröffentlicht | Nicht veröffentlicht |

Herausforderungen und Chancen für MiMo-7B

Herausforderungen:

- Wettbewerb: MiMo-7B ist in Nischen stark, im allgemeinen logischen Denken aber noch hinter Modellen wie Google Gemini 2.0.

- Markenimage: Xiaomi muss sich als KI-Player etablieren, nicht nur als Hardware-Hersteller.

- Skalierbarkeit: Die Leistung muss in realen Anwendungen stabil gehalten werden.

Chancen:

- Integriertes Ökosystem: Die Xiaomi-Integration eröffnet neue Möglichkeiten für vernetzte Erlebnisse.

- Open-Source-Community: Globale Zusammenarbeit beschleunigt die Entwicklung.

- Schwellenländer: Die Effizienz ist ideal für Regionen mit begrenzter Infrastruktur.

Fazit: Ein kleiner Schritt für Xiaomi, ein großer Sprung für die KI

MiMo-7B ist ein Meilenstein für Xiaomis KI-Strategie. Mit seinem Fokus auf logisches Denken, seiner Kompaktheit und der Open-Source-Veröffentlichung setzt es neue Maßstäbe. Von der Unterstützung von Schülern bis zur Softwareoptimierung – MiMo-7B hat das Potenzial, viele Bereiche zu revolutionieren. Die weitere Integration in Xiaomis Ökosystem und die wachsende Community werden MiMo-7B zu einem wichtigen Faktor in der KI-Entwicklung machen.

1 Gedanken zu „MiMo-7B: Xiaomis KI-Revolution – Klein, aber Oho!“